Moin Leute,

ich habe in meinem neuen Job u.A. dafür zu sorgen das unsere Firma interessant wirkt, das Werbung cool ist, das Webseiten interessant sind usw. Und da will ich nun bei den Kunden Punkten in dem ich ihnen beim Erstellen von Prontprodukten etwas zur Hand gehe und sie mit A.I. Bildern bei der Stange und auf dem Shop halten möchte. Soweit so gut.

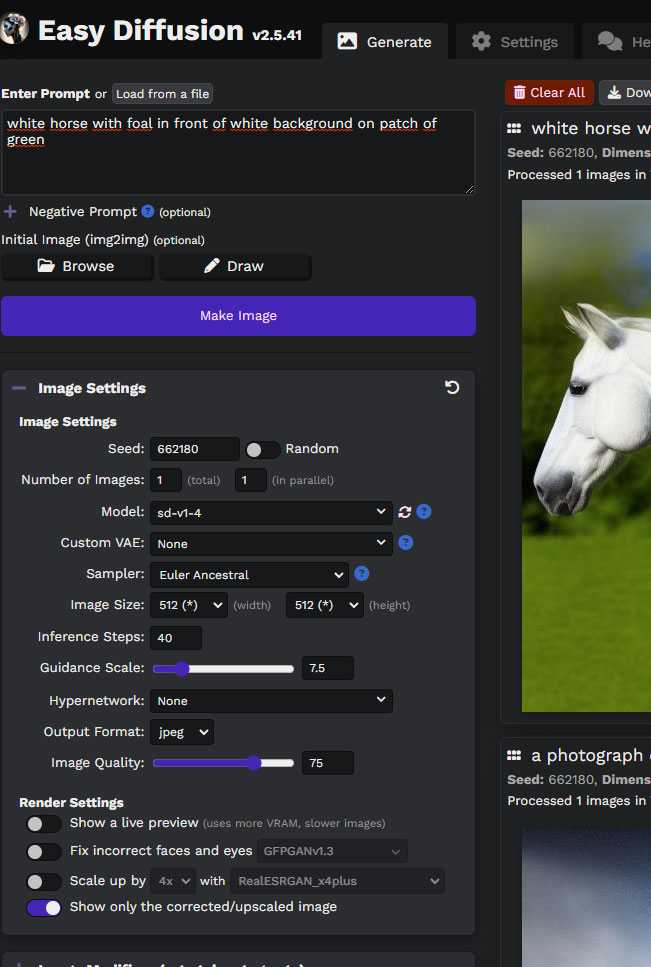

Easy Diffusion UI:

Was ich möchte:

- auf einem kleinen Server mit dicker GPU der hier im schön klimatisierten Serverraum steht soll EasyDiffusion laufen, von unserem Shop aus möchte ich nun per fastAPI auf EasyDiffusion zugreifen, einen Text Promt und ein paar Variablen übergeben (Seed, Image Size [width, height], Inference Steps usw.) und ein Bild zurück bekommen. Eine UI für EasyDiffusion gibt es ja auch bereits, die beinhaltet aber viel zu viel! Diese kennen die Meisten von euch ja aber auch vmtl

Was bereits geht:

- Testserver läuft mit Python. EasyDiffusion läuft, Bilder können über die UI über alle Rechner im Netzwerk (bisher nur Intern) generiert werden. Alles fein. Neue Hardware ist auch schon bestellt um ihn dann umziehen zu können. Ich habe mit der Stable Diffusion Pipeline, einem entsprechenden Python Script und einer Webseite im Netzwerk erfolgreich über cURL Bilder generiert. Leider beinhaltet diese Möglichkeit sehr viel Hendarbeit, es ist bedeutend langsamer und nicht so durchdacht (bin hier auch kein Profi), darum soll das jetzt über fastAPI und EasyDiffusion passieren. Ich wollte mit der eigenen Lösung nur testen ob das überhaupt machbar ist und ja, es ist machbar.

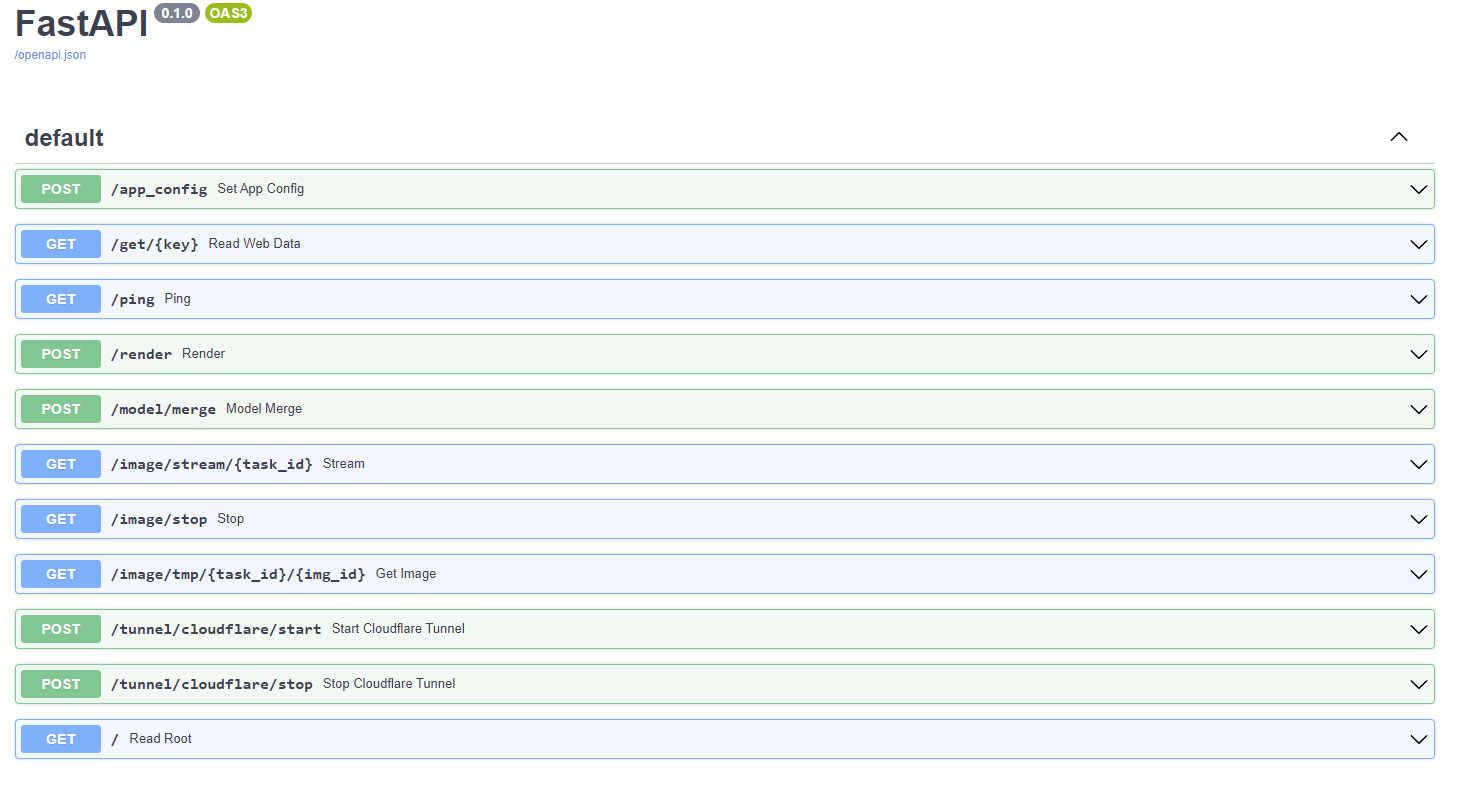

Meine Frage ist nun: Kennt sich wer mit dieser Thematik aus? Ich finde einfach keine vernünftige Anleitung zur fastAPI von StableDiffusion bzw. EasyDiffusion. Kein Wiki, nix. Bei meinem eigenen Script kann ich per POST und Generate-Image Bilder erzeigen, die fastAPI von EasyDiffusion ist mit jedoch ein Rätsel:

Ich habe Hoffnung das hier jemand sitzt der sowas ggf. sogar schon mal gemacht hat Auch wenn es vmtl aussichtslos ist

Auch wenn es vmtl aussichtslos ist

Ich bin gespannt

LG

godlike

ich habe in meinem neuen Job u.A. dafür zu sorgen das unsere Firma interessant wirkt, das Werbung cool ist, das Webseiten interessant sind usw. Und da will ich nun bei den Kunden Punkten in dem ich ihnen beim Erstellen von Prontprodukten etwas zur Hand gehe und sie mit A.I. Bildern bei der Stange und auf dem Shop halten möchte. Soweit so gut.

Easy Diffusion UI:

Was ich möchte:

- auf einem kleinen Server mit dicker GPU der hier im schön klimatisierten Serverraum steht soll EasyDiffusion laufen, von unserem Shop aus möchte ich nun per fastAPI auf EasyDiffusion zugreifen, einen Text Promt und ein paar Variablen übergeben (Seed, Image Size [width, height], Inference Steps usw.) und ein Bild zurück bekommen. Eine UI für EasyDiffusion gibt es ja auch bereits, die beinhaltet aber viel zu viel! Diese kennen die Meisten von euch ja aber auch vmtl

Was bereits geht:

- Testserver läuft mit Python. EasyDiffusion läuft, Bilder können über die UI über alle Rechner im Netzwerk (bisher nur Intern) generiert werden. Alles fein. Neue Hardware ist auch schon bestellt um ihn dann umziehen zu können. Ich habe mit der Stable Diffusion Pipeline, einem entsprechenden Python Script und einer Webseite im Netzwerk erfolgreich über cURL Bilder generiert. Leider beinhaltet diese Möglichkeit sehr viel Hendarbeit, es ist bedeutend langsamer und nicht so durchdacht (bin hier auch kein Profi), darum soll das jetzt über fastAPI und EasyDiffusion passieren. Ich wollte mit der eigenen Lösung nur testen ob das überhaupt machbar ist und ja, es ist machbar.

Meine Frage ist nun: Kennt sich wer mit dieser Thematik aus? Ich finde einfach keine vernünftige Anleitung zur fastAPI von StableDiffusion bzw. EasyDiffusion. Kein Wiki, nix. Bei meinem eigenen Script kann ich per POST und Generate-Image Bilder erzeigen, die fastAPI von EasyDiffusion ist mit jedoch ein Rätsel:

Ich habe Hoffnung das hier jemand sitzt der sowas ggf. sogar schon mal gemacht hat

Auch wenn es vmtl aussichtslos ist

Auch wenn es vmtl aussichtslos ist

Ich bin gespannt

LG

godlike