Hallo, ich hab eine Frage bezüglich einer Webseite. Es handelt sich um eine Webseite eines Freundes. Gehostet ist die Seite bei Strato, alledings wird die Seite nicht gefunden, also über Google. Bei den Metadaten sind entsprechende Keywords eingetragen, der "Title" ist auch korrekt angegeben. An was könnte das liegen, dass die Seite nicht einmal auf der fünften Seite steht???

-

Hallo liebe Userinnen und User,

nach bereits längeren Planungen und Vorbereitungen sind wir nun von vBulletin auf Xenforo umgestiegen. Die Umstellung musste leider aufgrund der Serverprobleme der letzten Tage notgedrungen vorverlegt werden. Das neue Forum ist soweit voll funktionsfähig, allerdings sind noch nicht alle der gewohnten Funktionen vorhanden. Nach Möglichkeit werden wir sie in den nächsten Wochen nachrüsten. Dafür sollte es nun einige der Probleme lösen, die wir in den letzten Tagen, Wochen und Monaten hatten. Auch der Server ist nun potenter als bei unserem alten Hoster, wodurch wir nun langfristig den Tank mit Bytes vollgetankt haben.

Anfangs mag die neue Boardsoftware etwas ungewohnt sein, aber man findet sich recht schnell ein. Wir wissen, dass ihr alle Gewohnheitstiere seid, aber gebt dem neuen Board eine Chance.

Sollte etwas der neuen oder auch gewohnten Funktionen unklar sein, könnt ihr den "Wo issn da der Button zu"-Thread im Feedback nutzen. Bugs meldet ihr bitte im Bugtracker, es wird sicher welche geben die uns noch nicht aufgefallen sind. Ich werde das dann versuchen, halbwegs im Startbeitrag übersichtlich zu halten, was an Arbeit noch aussteht.Neu ist, dass die Boardsoftware deutlich besser für Mobiltelefone und diverse Endgeräte geeignet ist und nun auch im mobilen Style alle Funktionen verfügbar sind. Am Desktop findet ihr oben rechts sowohl den Umschalter zwischen hellem und dunklem Style. Am Handy ist der Hell-/Dunkelschalter am Ende der Seite. Damit sollte zukünftig jeder sein Board so konfigurieren können, wie es ihm am liebsten ist.

Die restlichen Funktionen sollten eigentlich soweit wie gewohnt funktionieren. Einfach mal ein wenig damit spielen oder bei Unklarheiten im Thread nachfragen. Viel Spaß im ngb 2.0.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Problem mit Webseite

- Ersteller R.Carlos

- Erstellt am

eraser

Stinkstiefel

- Registriert

- 21 Juli 2013

- Beiträge

- 3.775

Crawling/Indexierung wurde nicht aus Versehen ausgeschalten?

Indexierung bei Google (und Bing) kann man auch selbst triggern, danach heißt es Suchmaschinenoptimierung.

Edit: Google inkl. kleinen Tools

Bing (wenn ich mich nicht täusche)

Indexierung bei Google (und Bing) kann man auch selbst triggern, danach heißt es Suchmaschinenoptimierung.

Edit: Google inkl. kleinen Tools

Bing (wenn ich mich nicht täusche)

- Registriert

- 3 Aug. 2014

- Beiträge

- 28.573

Das die Inhalte erst bei aktiviertem Javascript zu sehen sind oder darüber zugänglich sind. Das ist nach wie vor ein Blocker bzw. könnte einer in deinem Fall sein. Einfach mal "NoScript" als Addon (Firefox) installieren und versuchen auf der Seite zu surfen, was du dann siehst, ist fast auch das was Google sieht.

Ich würde mir ein Google Konto anlegen (Freund) die Verifikationsdatei von Google auf den Webspace laden, den Account bestätigen und auf Crawler-Error schauen, warum die Seite nicht oder nur teilweise oder gar nicht indexiert werden kann. Wie hier auch vorgeschlagen wird.

Ich würde mir ein Google Konto anlegen (Freund) die Verifikationsdatei von Google auf den Webspace laden, den Account bestätigen und auf Crawler-Error schauen, warum die Seite nicht oder nur teilweise oder gar nicht indexiert werden kann. Wie hier auch vorgeschlagen wird.

Wenn die Webseite bestätigt ist, kann man das Indexieren anstoßen.

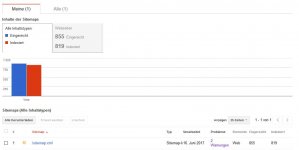

Hilfreich ist auch eine Sitemap. Wenn die Seiten indexieren sind, schaut das etwa so aus:

Warnungen und Fehler werden auch angezeigt und die sollte man möglichst beheben.

Anschließend mal schauen, wie die Seite in der Suche ausschaut usw.

Hilfreich ist auch eine Sitemap. Wenn die Seiten indexieren sind, schaut das etwa so aus:

Warnungen und Fehler werden auch angezeigt und die sollte man möglichst beheben.

Anschließend mal schauen, wie die Seite in der Suche ausschaut usw.

- Registriert

- 14 Juli 2013

- Beiträge

- 5.376

Das ist, soweit ich weiss, leider(!) schon lange nicht mehr so.Das die Inhalte erst bei aktiviertem Javascript zu sehen sind oder darüber zugänglich sind. Das ist nach wie vor ein Blocker bzw. könnte einer in deinem Fall sein. Einfach mal "NoScript" als Addon (Firefox) installieren und versuchen auf der Seite zu surfen, was du dann siehst, ist fast auch das was Google sieht.

Jester

★★★★☆ (Kasparski)

Entscheidende Frage: ist die Seite überhaupt in den Suchergebnissen drin, vlt, nur sehr weit hinten?

-> Google Suche nach site:[domain].[tld] also z. B. site:ngb.to

Ja: der Inhalt (most likely), die Struktur und die offpage-Maßnahmen (Backlinks tec.) sind nicht gut genug oder Seite ist noch zu neu. Eine neue Seite (Domain) kann prima optimiert werden, rankt sie zu schnell zu gut, kommt sie in Überwachung (Sandbox), in der Zeit gibt es keine bzw. nur stark abgeschwächte Verbesserungen im Ranking.

Maßnahmen: Inhalt verbessern, Struktur prüfen und verbessern, Seitentitel sinnvoll überarbeiten, für Trusted Links und Back Links sorgen, SEO also

Nein:

1. Ist das Crawling vielleicht unterdrückt?

-> robots.txt prüfen, ob vielleicht alles disallowed ist (z. B. User-agent:* disallow:/)

-> Quelltext prüfen, ob vieleicht <meta name="robots" content="noindex, nofollow"> oder nur "noindex" drin steht

-> Gibts den Inhalt vlt. nur mit einer Anmeldung? htaccess prüfen

2. Google Webmastertools einrichten, Google Analytics einrichten, Google Trends verwenden, um die Keywords und deren Suchvolumen beurteilen zu können, beste Keywords in Titel und Inhalt aufnehmen

3. Seite bei Bing manuell anmelden/vorschlagen

-> Google Suche nach site:[domain].[tld] also z. B. site:ngb.to

Ja: der Inhalt (most likely), die Struktur und die offpage-Maßnahmen (Backlinks tec.) sind nicht gut genug oder Seite ist noch zu neu. Eine neue Seite (Domain) kann prima optimiert werden, rankt sie zu schnell zu gut, kommt sie in Überwachung (Sandbox), in der Zeit gibt es keine bzw. nur stark abgeschwächte Verbesserungen im Ranking.

Maßnahmen: Inhalt verbessern, Struktur prüfen und verbessern, Seitentitel sinnvoll überarbeiten, für Trusted Links und Back Links sorgen, SEO also

Nein:

1. Ist das Crawling vielleicht unterdrückt?

-> robots.txt prüfen, ob vielleicht alles disallowed ist (z. B. User-agent:* disallow:/)

-> Quelltext prüfen, ob vieleicht <meta name="robots" content="noindex, nofollow"> oder nur "noindex" drin steht

-> Gibts den Inhalt vlt. nur mit einer Anmeldung? htaccess prüfen

2. Google Webmastertools einrichten, Google Analytics einrichten, Google Trends verwenden, um die Keywords und deren Suchvolumen beurteilen zu können, beste Keywords in Titel und Inhalt aufnehmen

3. Seite bei Bing manuell anmelden/vorschlagen

virtus

Gehasst

Jester hat bereits das übliche Vorgehen erklärt:

(1) Zunächst prüfen, ob deine Seite überhaupt indexiert ist

(2.1) Falls die Seite noch nicht indexiert ist, solltest du prüfen, ob das an deinen Website-Einstellungen liegt, zum Beispiel einer robots.txt, welche Indexierung verbietet oder ob der Crawler nur noch nicht deine Seite kennt. Der Crawler erfährt von deiner Seite, wenn sie von anderen Seiten aus verlinkt wird oder indem du manuell eine Indexierung auslöst. Für letzteres kannst du zum Beispiel über die Links, die LadyRavenous gepostet hat, nutzen.

(2.2) Falls die Seite bereits indexiert ist, aber im Ranking an einer schlechten Position, dann kann man sich das Problem genauer anschauen.

Prinzipiell gilt:

SEO ist ein Marketingbegriff und nicht wirklich im Interesse von Google (bzw. anderen Suchmaschinen). Wird dir also die Maßnahme empfohlen, mit der du unmittelbar in die TOP 10 bei google kommst, kannst du davon ausgehen, dass das (a) Abzocke ist und (b) Google dich in absehbarer Zeit dafür abstrafen wird. Häufig spricht man in diesem Zusammenhang dann auch von black SEO. Am Besten ist es, wenn du dir darüber nicht allzu große Gedanken machst. Maßnahmen, welche das Ranking manipulieren, haben in aller Regel ohnehin nur kurzzeitige Wirkung und Suchmaschinenbetreiber ändern regelmäßig ihre Algorithmen, um das Ausnutzen dieser Maßnahmen zu unterbinden. Es ist sinnvoller deine Inhalte passend zu präsentieren, als viel Energie und möglicherweise noch Geld in Manipulation zu stecken.

Andererseits ist es natürlich möglich, Suchmaschinen die Inhalte einer Website 'besser' zu präsentieren und das wiederum ist explizit gewünscht. Das wird in Abgrenzung zu black SEO häufig auch als white SEO bezeichnet.

Wie also präsentierst du deine Webseite so, dass eine Suchmaschine am besten damit klar kommt?

(1) Zunächst prüfen, ob deine Seite überhaupt indexiert ist

(2.1) Falls die Seite noch nicht indexiert ist, solltest du prüfen, ob das an deinen Website-Einstellungen liegt, zum Beispiel einer robots.txt, welche Indexierung verbietet oder ob der Crawler nur noch nicht deine Seite kennt. Der Crawler erfährt von deiner Seite, wenn sie von anderen Seiten aus verlinkt wird oder indem du manuell eine Indexierung auslöst. Für letzteres kannst du zum Beispiel über die Links, die LadyRavenous gepostet hat, nutzen.

(2.2) Falls die Seite bereits indexiert ist, aber im Ranking an einer schlechten Position, dann kann man sich das Problem genauer anschauen.

Prinzipiell gilt:

SEO ist ein Marketingbegriff und nicht wirklich im Interesse von Google (bzw. anderen Suchmaschinen). Wird dir also die Maßnahme empfohlen, mit der du unmittelbar in die TOP 10 bei google kommst, kannst du davon ausgehen, dass das (a) Abzocke ist und (b) Google dich in absehbarer Zeit dafür abstrafen wird. Häufig spricht man in diesem Zusammenhang dann auch von black SEO. Am Besten ist es, wenn du dir darüber nicht allzu große Gedanken machst. Maßnahmen, welche das Ranking manipulieren, haben in aller Regel ohnehin nur kurzzeitige Wirkung und Suchmaschinenbetreiber ändern regelmäßig ihre Algorithmen, um das Ausnutzen dieser Maßnahmen zu unterbinden. Es ist sinnvoller deine Inhalte passend zu präsentieren, als viel Energie und möglicherweise noch Geld in Manipulation zu stecken.

Andererseits ist es natürlich möglich, Suchmaschinen die Inhalte einer Website 'besser' zu präsentieren und das wiederum ist explizit gewünscht. Das wird in Abgrenzung zu black SEO häufig auch als white SEO bezeichnet.

Wie also präsentierst du deine Webseite so, dass eine Suchmaschine am besten damit klar kommt?

- Der wichtigste Punkt ist die Struktur: Mit Hilfe von HTML, insbesondere HTML5, ist es möglich eine saubere Struktur deiner Inhalte zu gewährleisten. Artikel, Beiträge, Überschriften, Autoren, Daten etc. können mit Hilfe von HTML als solche gekennzeichnet werden. Auf diese Weise ist es für eine Suchmaschine einfacher, sich auf deiner Webseite zurecht zu finden und eine Analyse durchzuführen.

Kennzeichnest du beispielsweise auf deinem Blog auf diese Weise, den Autor von Beiträgen und publizierst regelmäßig unter einem bestimmten Pseudonym, dann wird deine Seite natürlich besser gerankt, wenn nach diesem Pseudonym gesucht wird. Das funktioniert natürlich nur, wenn die Suchmaschine "versteht", dass das Pseudonym als Autor eine besondere Rolle auf deiner Webseite spielt. - Außerdem können natürlich auch Indexierungs-Regeln (robots.txt) helfen, das Ranking deiner Seite zu verbessern.

Sind unter http://deine-seite.de und http://www.deine-seite.de und vielleicht auch http://dein-name.de/deine-seite/ identische Inhalte erreichbar, ist es besser der Suchmaschine mitzuteilen, dass sie nur eine dieser Seiten zu indexieren und die anderen zu ignorieren. (Besser wäre es natürlich eine Duplizierung der Inhalte gänzlich zu vermeiden!) - Webseiten, deren Inhalte (ausschließlich) mit JavaScript generiert werden, können mittlerweile von Google gelesen werden, allerdings, so meine Information, wirkt sich das negativ auf das Ranking aus.

- Außerdem rankt Google Seiten, die nicht über eine verschlüsselte Verbindung erreichbar sind (https) ebenfalls ab.